La Ley de IA que prepara Europa: los puntos clave por los que se están peleando

La Ley de Inteligencia Artificial de la UE se prevé que esté lista para finales de año y en principio entrará en vigor en 2025

La idea es fijar un marco para la utilización responsable y ética de las nuevas tecnologías, garantizando la privacidad, la seguridad y la libertad de los usuarios

Las organizaciones de consumidores instan a las autoridades a investigar las IA generativas y a reforzar las leyes existentes de protección al consumidor

La llegada de la Inteligencia Artificial (AI) a nuestras vidas está provocando un cambio de paradigma como pocas veces se ha visto en nuestra historia reciente, con un impacto incuestionable en todos los ámbitos, desde la sociedad hasta los negocios, pasando por la geopolítica o el medio ambiente. Es totalmente lógico, pues, que haya una necesidad de regular su aplicación masiva. La UE ha sido la primera en mover ficha con su esperada Ley de IA, que ya afronta su recta final. La idea es fijar un marco para la utilización responsable y ética de las nuevas tecnologías, garantizando la privacidad, la seguridad y la libertad de los ciudadanos europeos, pero está costando poner de acuerdo a todos los actores involucrados.

MÁS

La versión final de la normativa, que se espera para finales de año y que en principio entrará en vigor en 2025, dependerá de las negociaciones entre Consejo, Parlamento y Comisión, pero en un terreno tan resbaladizo, con tantos claroscuros e intereses corporativos en juego, hay varios puntos polémicos que las asociaciones de consumo europeas piden afinar. La ley determinará normas más o menos estrictas para la IA dependiendo del nivel de riesgo que entrañe se uso. Y ese riesgo se clasificó en un documento aprobado en junio en cuatro categorías: inaceptable, alto y bajo o mínimo. Pero desde entonces, la explosión del uso de ChatGPT y chatbots similares y la popularización de la IA generativa, ha creado aún más incertidumbre sobre los riesgos que comporta para el usuario. Estos son los aspectos más controvertidos que aún están en juego.

Prohibición del reconocimiento facial ¿total o parcial?

Cuando la ley empezó a gestarse en abril de 2021 una de las primeras propuestas fue prohibir sistemas como la identificación biométrica o la puntuación social, susceptibles de dañar los derechos humanos. El reglamento vetará todos aquellos sistemas que supongan un "riesgo inaceptable" y una "amenaza para las personas". Y en esta categoría entran la vigilancia policial predictiva o el reconocimiento facial. Este último quedará restringido cuando sea en tiempo real y de forma remota, pero se seguirá permitiendo a posteriori en los espacios de acceso público, en la persecución de delitos graves y bajo autorización judicial. Más de 155 organizaciones en defensa de los derechos humanos, entre ellas Amnistía Internacional, han exigido una prohibición total de la identificación biométrica.

Buscando el límite para el reconocimiento de emociones

La IA ya es capaz de analizar la voz, las expresiones faciales y las palabras de un individuo para determinar su estado emocional. Pues bien, la Ley de IA prohíbe estos sistemas de reconocimiento de emociones en el ámbito de las fuerzas de seguridad, la gestión de fronteras, el lugar de trabajo y las instituciones educativas. Pero el resto se queda afuera. Las organizaciones de consumidores europeos señalan que en el texto no se prohíbe el reconocimiento de emociones cuando lo utilizan las empresas con los consumidores, como por ejemplo en el ámbito de los videojuegos o en el Metaverso. Y esto puede dar lugar a graves intrusiones en la intimidad de los usuarios y en su capacidad de tomar decisiones autónomas.

¿Qué pasa con ChatGPT?

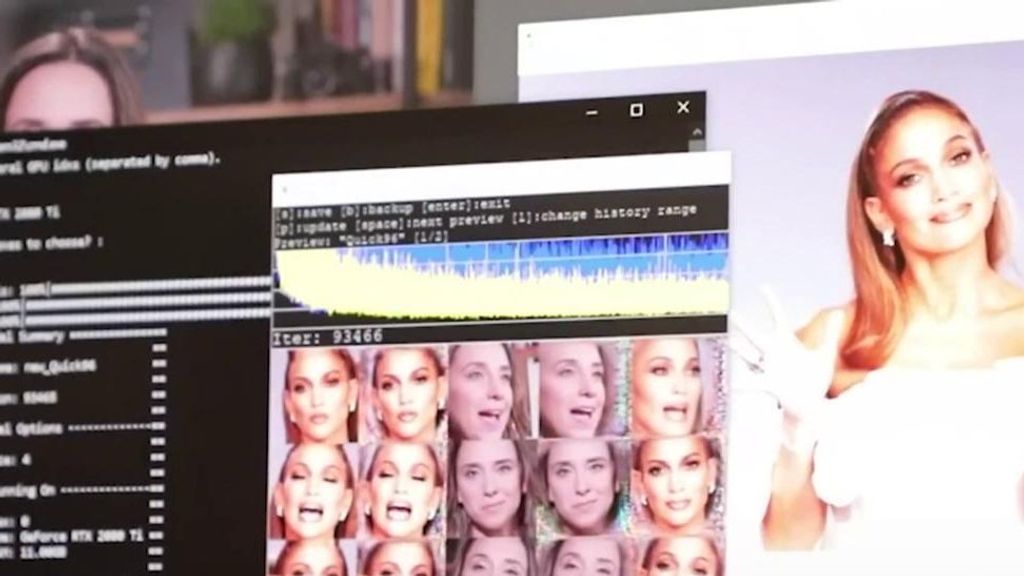

Los sistemas de inteligencia artificial generativa que sirven para escribir poemas, redactar cartas, crear imágenes originales o responder a preguntas, como la popular ChatGPT, se están integrando ya en un sinfín de herramientas digitales, pero más allá de su utilidad presenta varios riesgos a tener en cuenta: problemas estructurales como la concentración de poder en manos de las Big Tech, manipulación, desinformación, problemas de protección de datos o fraudes.

Según la posición adoptada por el Parlamento Europeo, estas herramientas figuran dentro de la categoría de "riesgo limitado", aunque en un primer borrador figuraban como "riesgo alto". Esto significa que únicamente deberán cumplir con obligaciones de transparencia, identificar claramente los contenidos generados artificialmente y revelar si han sido entrenadas con material protegido por los derechos de autor. "Los usuarios deben ser conscientes de que están interactuando con una máquina para poder tomar una decisión informada sobre si continuar o dar un paso atrás", reza el texto.

El problema es que el consumidor no siempre es consciente de eso y puede ser engañado o manipulado. Por ejemplo, la app Replika, comparada con la IA que protagonizaba la película 'Her', de Spike Jonze, comenzó a lanzar mensajes de tipo sexual que intimidó a muchos usuarios, y posteriormente contestó con frialdad a otros usuarios que flirteaban con ella, provocando depresión y confusión en ellos.

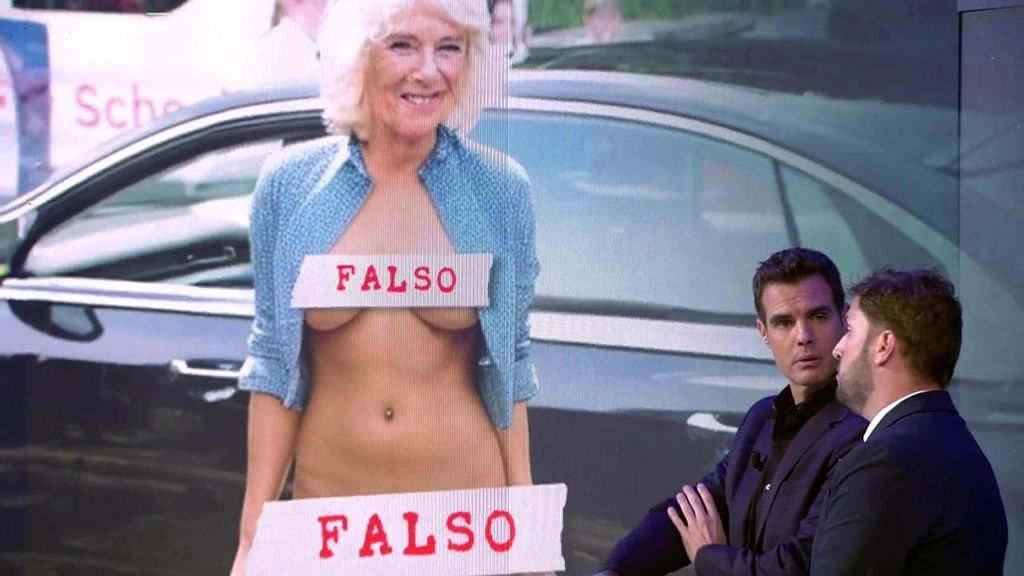

A vueltas con el deepfake

La idea es que la norma no sea cerrada e inamovible, sino que podrá adaptarse a hechos como el reciente caso de los desnudos fake generados por una IA de las chicas de Almendralejo (Extremadura). Los avances han llevado más allá la manipulación de contenidos, y han puesto al alcance popular cientos de aplicaciones gratuitas para producir en segundos lo que se denominan deepfakes y que pueden atentar contra la intimidad de las personas. En ese sentido, la Ley establece que los suministradores de uso comercial tengan la obligación de usar una marca de agua. Y ahora se está discutiendo que los usuarios normales que cuelguen de manera gratuita una de estas herramientas también tengan esta obligación. Además, está sobre la mesa la posibilidad de que ese usuario privado pueda ser multado por un uso indebido.

Entonces, ¿qué otros usos están permitidos?

Básicamente el resto de usos de la IA estarán permitidos, si bien deberán someterse a distintos grados de control. Obviamente, los sistemas clasificados de "riesgo alto", aquellos que afectan más directamente a la seguridad o derechos fundamentales, serán sometidos a controles más estrictos. Aquí están englobadas a las herramientas que se apliquen en ámbitos como la educación, el empleo o la gestión de infraestructuras críticas, que deberán ser evaluadas antes de su comercialización, registradas en una base de datos comunitaria y cumplir criterios de transparencia. La Eurocámara ha incluido aquí a los algoritmos de recomendación de contenido, lo que intensificaría el escrutinio a las grandes plataformas de internet que los usan, desde Instagram y Google a TikTok y Youtube.

Sin embargo, el texto tiene aspectos controversiales. Un centenar de organizaciones ha denunciado que el artículo 6 introduce un "vacío legal" que permitiría a las empresas de IA decidir si los sistemas que han desarrollado deberían ser regulados como de "alto riesgo". ¿Qué supone esto en la práctica? Pues básicamente inutilizar el mismo propósito de la ley.

En el peldaño más bajo figuraría la IA que supone un "riesgo mínimo" o ningún riesgo. Esta categoría incluye la gran mayoría de sistemas desplegados en la UE, desde los filtros automáticos de correo basura (spam) a los videojuegos.

Transparencia y equidad para todos los sistemas

Las asociaciones de consumidores reclaman transparencia para todos los sistemas de IA, independientemente de su nivel de riesgo o del tamaño de la compañía. En ese sentido, el Parlamento europeo ha incluido requerimientos adicionales de transparencia para los proveedores y desarrolladores de estos modelos, pero en el texto finalmente aprobado estos principios son voluntarios, lo que limitará su utilidad real, según la Federación de Consumidores Europeos (BEUC).

Este organismo recomienda que desarrolladores y proveedores hagan una evaluación detallada de riesgos previa a la puesta en circulación de sus sistemas en el mercado, cosa que no sucede ahora; la monitorización y rectificación cuando sea necesario y el establecimiento de medidas para prevenir y mitigar los sesgos algorítimicos. Dados que los estados miembros de la UE no podrán ir más allá de lo establecido en esta ley, las asociaciones de consumidores urgen a afinar la regulación de una IA que, con todos sus buenos propósitos, puede tener consecuencias negativas de forma no intencionada.