Experto en IA, sobre la rebelión de las máquinas: "Hay una mínima posibilidad de supervivencia"

El cofundador del MIRI advierte de un futuro en el que la IA será como "una civilización alienígena que piensa mil veces más rápido que nosotros”

"Tengo la sensación de que nuestro tiempo restante actual se parece más a cinco años que a 50. Podrían ser dos años, podrían ser 10", pronostica el investigador en 'The Guardian'

Tu salud, el cuidado de tus padres y tu coche: diez cosas que sí mejorará la IA

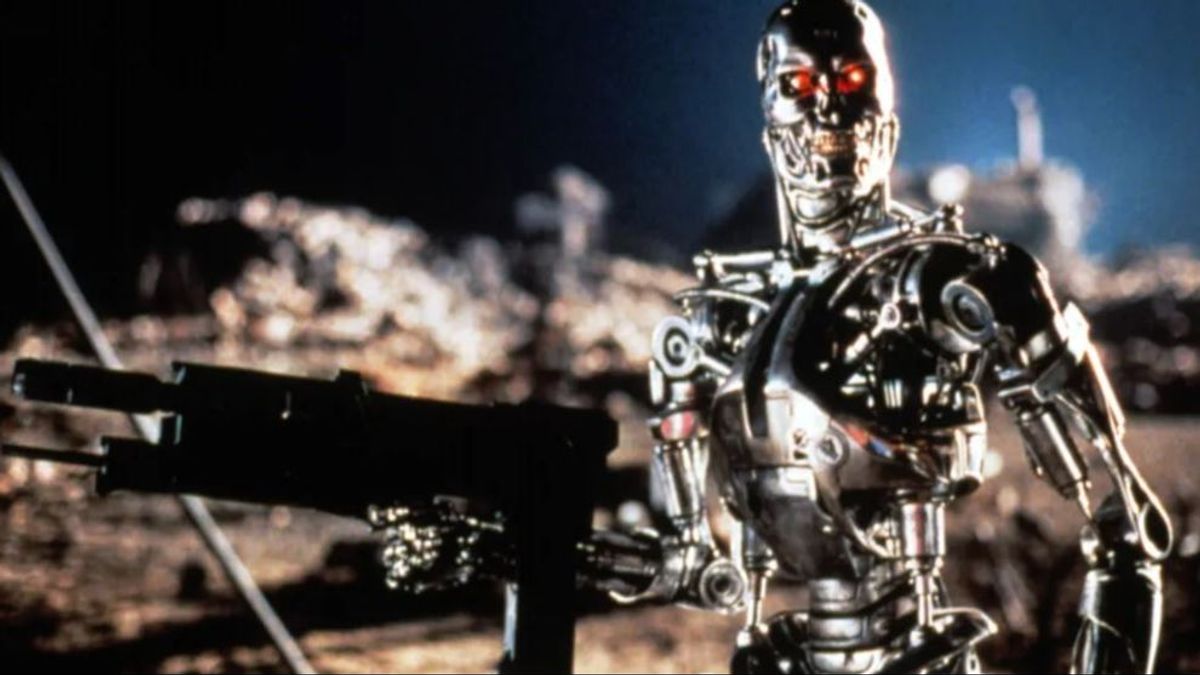

En la saga 'Terminator' la inteligencia artificial Skynet llegaba la conclusión de que la mayor amenaza para la humanidad que tenía que proteger era la misma humanidad, por lo programaba su exterminio. Aquella rebelión de la máquinas que conducía al holocausto nucler era solo ficción y no refleja la realidad de la tecnología actual. ¿O sí? El experto en IA Eliezer Yudkowsky, cofundador del Instituto de Investigación de Inteligencia Artificial (MIRI), no tiene dudas de que el futuro de la humanidad es bastante sombrío, aunque “tenemos una mínima posibilidad de supervivencia”.

MÁS

Ante la pregunta en una reciente entrevista en 'The Guardian' de qué nos espera como especie ante el desarrollo de la IA, Yudkowsky se muestra bastante tajante: "Si me pones contra una pared y me obligas a poner probabilidades a las cosas, tengo la sensación de que nuestro tiempo restante actual se parece más a cinco años que a 50. Podrían ser dos años, podrían ser 10”. Una predicción medio sarcástica que no oculta su frustración con el mundo que estamos construyendo. “El problema es que la gente no se da cuenta”, agrega.

¿Un cerebro encerrado en una caja?

El gran temor del científico es que la IA avance demasiado rápido y los seres humanos no seamos capaces de controlarla. "No debe considerarse como un cerebro encerrado en una caja que hace lo que se le pide, porque una IA más avanzada que los humanos encontrará formas de salir de la caja", advierte. Para comprender hacia dónde se dirigen las cosas, dice en la entrevista, hay que visualizar "una civilización alienígena que piensa mil veces más rápido que nosotros”, en muchas y muchas cajas, demasiadas para poder desmantelarlas todas, en caso de decidiéramos intentarlo siquiera.

El experto lleva tiempo advirtiendo de los peligros de la inteligencia artificial. Hace menos de un año publicó un artículo en 'Time' que aconsejaba cerrar los centros de datos donde se encuentran y entrenan las IA. “Sin la precisión y preparación, el resultado más probable es que una IA no haga lo que queremos y no se preocupe por nosotros ni por la vida sensible en general. Ese tipo de atención es algo que, en principio, podría incorporarse a una IA, pero no estamos preparados y actualmente no sabemos cómo hacerlo”, explicaba en aquel texto.

Otras voces de alarma

La voz un tanto pesimista de Yudkowsky no es la única. Geoffrey Hinton, ex vicepresidente de Ingeniería de Google, exponía sus temores en una entrevista a 'The New York Times'. "La idea de que estas cosas en realidad podrían volverse más inteligentes que las personas, algunas personas lo creían", explicaba. "Pero la mayoría de la gente pensaba que estaba muy lejos. Yo pensaba que estaba muy lejos. Pensaba que faltaban entre 30 y 50 años o incluso más. Obviamente, ya no pienso eso", decía.

Y hace poco menos de un año más de 1.000 expertos firmaban una carta abierta en la que instaban a pausar la implementación de las nuevas IA durante seis meses con el objetivo de frenar lo que denominaban "una peligrosa carrera que está llevando al desarrollo de modelos más impredecibles y con capacidades cada vez mayores".